Igazán kényes helyeken az erős jelszavak és a szigorú jelszópolitika már nem elegendő. Mi több, a többlépcsős hitelesítés is kijátszható, ahogy arról korábban már dobtam is egy posztot.

Igazán kényes helyeken az erős jelszavak és a szigorú jelszópolitika már nem elegendő. Mi több, a többlépcsős hitelesítés is kijátszható, ahogy arról korábban már dobtam is egy posztot.

Ha még az sem szavatolja a biztonságos beléptetést, hogy a felhasználónak a felhasználói neve és a jelszava mellett még egy egyszer használatos, például SMS-ben érkező vagy mobilalkalmazás által generált tokent is meg kell adnia, akkor mégis mi? Avagy mi az, ami szinte száz százalékosan azonosít egy-egy felhasználót? Igen, a viselkedése, amit a gép fel is ismer. Na de nem szaladnék annyira előre.

Nemrég több nagy iparági óriás is ismertette azokat a trendeket és friss kutatási eredményeket, amikből egészen dermesztő adatok derülnek ki, már ami az információvédelmet egészében illeti.

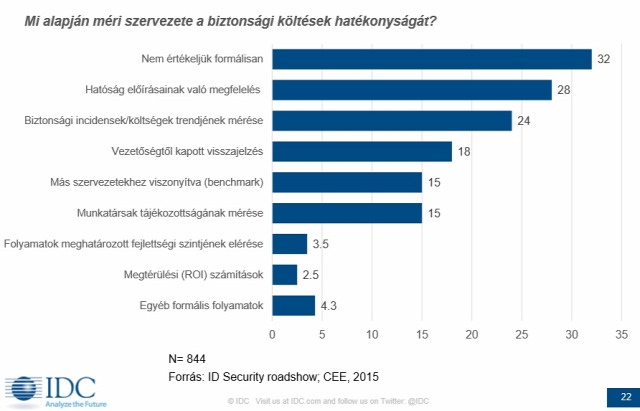

Az IDC egyik legújabb felmérése szerint a szervezetek többsége még mindig nem méri semmilyen módon azt, hogy az az összeg, amit információbiztonságra fordítanak, mennyire is hatékony. Míg nagyon sok esetben csak a hatósági feltételeknek kell megfelelniük, a harmadik legnagyobb csoportba pedig azok tartoznak, akik klasszikus kockázatbecslést végeznek, amikor kiértékelik egy-egy IT biztonsági incidens bekövetkezésének valószínűségét megszorozva az általa okozott kárral és ezt vetik össze azzal, hogy mennyit is költsenek informatikai biztonságra.

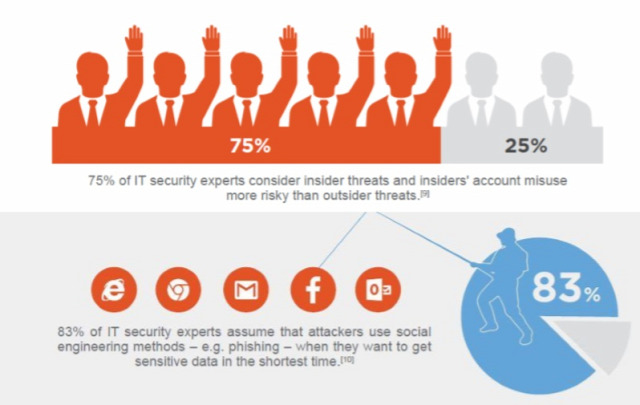

Olyan szempontból évek óta alig történt változás, hogy a leggyengébb láncszem nagyon sok esetben maga az ember, azaz az incidensek többsége megelőzhető lenne tudatosabb felhasználói viselkedés mellett. Nemrég egy konferencián az IT Services Hungary ismertetett egy, stílusosan Mikulásnapon elvégzett kísérletet, amiben egy auditor Télapónak öltözve ballagott be az ITSH egyik telephelyére nem mellékesen alaposan bekamerázva. Sehol nem állították meg, hogy igazolja a kilétét, szinte mindenki készségesen beengedte, így emberünk alaposan szét tudott nézni az irodákban, márpedig tudjuk, hogy egy hely bejárhatósága a social engineering támadások szempontjából aranybánya. Nem pusztán a helyismeret miatt, jobban belegondolva eléggé rizikós lehet, ha rejtett kamerával simán rögzíthető az, ami a monitorokon vagy esetleg nyomtatva megjelenik. Az öröm nem tartott sokáig, az alkalmazottaknak a Mikulás látogatása után levetítették a teljes felvételt, bemutatva azt, hogy az ál-Mikulás csak azt nem látott, amit nem is akart.

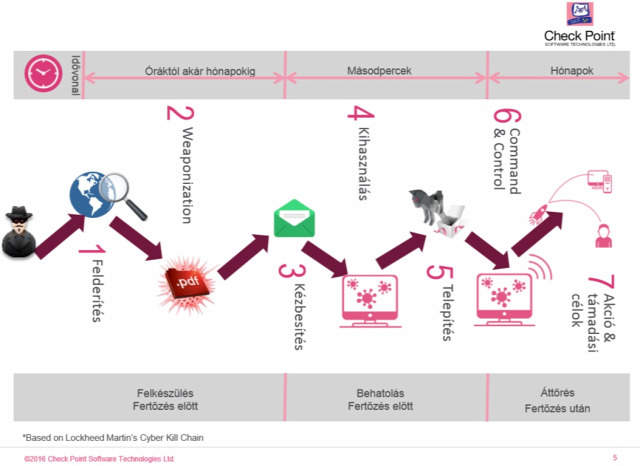

Márpedig a kifinomult, célzott támadások rendszerint hosszas előzetes információgyűjtéssel kezdődnek a megtámadni kívánt szervezettel kapcsolatban. A Lockheed Martin által csak Cyber Kill Chainnek nevezett ábra magyarra fordított változatát a CheckPoint idei diasorából vettem át, amiből kiderül az is, hogy egy-egy kémprogram telepítése ugyan néhány másodperc, a kémprogramok pedig nem kevés ideig, átlagosan 200 napig lappangnak egy hálózatban anélkül, hogy észlelnék őket, ráadásul ez az idő folyamatosan egyre hosszabbra nyúlik.

Nem csak azért nyúlik egyre hosszabbra, mert a malware-ek sokszor azért, hogy ne keltsenek feltűnést, nem lépnek azonnal akcióba, hanem azért is, mert az egész folyamat évről évre egyre kifinomultabbá válik. A kémprogramok elleni védekezés egyik bevett módja az, hogy minden kívülről jövő adat, így az esetlegesen rosszindulatú kód is először egy sandbox környezetben fut, azaz egy olyan virtuális gépen, amiben hiába kezdene el működni elvben, nem tenne kárt a valós rendszerben. 3-4 évvel ezelőttre teszem az első olyan kémprogramok megjelenését, amik már kellően rafináltak voltak ahhoz, hogy észleljék azt, ha nem valós, hanem virtualizált környezetben vannak, így ekkor nem tesznek semmit, hogy elkerüljék a feltűnést. Másrészt technikák egész sora jelent meg, amivel sok esetben lehetővé válik a sandbox-kitörés [sandbox evasion] a vírusok számára.

Ahogy a poszt elején is írtam, az incidensek bekövetkezése mégis leggyakrabban emberi mulasztás vagy hiba miatt következik be, mi több, rendszerint ezek járnak a legtöbb kárral, így teljesen érthető, hogy a kutatások egy nagyon preferált területe lett éppen ezeknek az emberi hibáknak az időben történő kiszúrása.

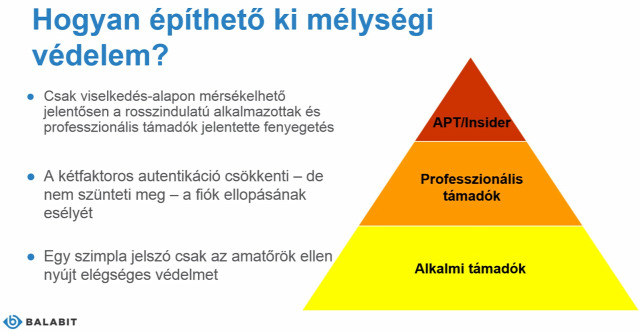

Ahogy frappánsabban össze sem lehetett volna foglalni, a múlt a határvonal-alapú biztonság volt, amit többek közt klasszikus tűzfalakkal oldottak meg, manapság a legelterjedtebb az identitás-alapú biztonság, azaz amikor az előzőn túl egyre erősebb és erősebb azonosítási technikákkal látnak el rendszereket, a jövő pedig a viselkedés alapú biztonságé lesz.

Ami a jelent illeti, a többlépcsős azonosítás korában sokan lobbiznak a biometrikus azonosítást használó technikák elterjedése mellett, amit személy szerint én már akkor is egy igencsak fancy, ámde annál blődebb dolognak tartottam, amikor először olvastam róla komolyabban. A biometrikus azonosítással személy szerint az elvi problémát abban látom, hogy nem valami bölcs dolog olyan azonosításra támaszkodni, aminél az azonosításhoz használt információ nem változtatható meg. Többször igazolták már, hogy az okoseszközök ujjlenyomat-azonosítója arcpirító egyszerűséggel megtéveszthető, a retina mintázatát felismerő kamerák működése drága, körülményes és szintén becsapható. Sajnos a biometrikus azonosítás gyengeségei nem csak az emlegetett okoskütyük esetén jellemző, hanem drága és megbízhatónak hitt rendszerek esetén is. Ujjlenyomat? Retina? Írisz? Arc? Vénalefutás? Kéretik elhinni, hogy mindegyik sokkal biztonságosabbnak van kikiáltva, mint amennyire azok.

A Balabit friss felmérései szerint az információbiztonsági szakértők gyakorlatilag mindegyike egyetért abban, hogy az incidensek egy jelentős része az alkalmazottak gondatlanságára vagy vezethetők vissza, esetleg ők maguk az insider támadók, valamint a gondatlansággal illetve szándékolt támadásokkal okozható kár nyilván annál nagyobb, minél több jogosultsággal rendelkezik az adott alkalmazott.

Innen eléggé értelemszerű, hogy akiknek a legnagyobb gondossággal kell vigyázni a munkáját illetve a legjobban védeni a hozzáféréseiket a külső támadóktól, a legmagasabb jogosultsági szinttel rendelkező rendszergazdák.

Itt lépett színre úgy igazán a felhasználó viselkedési mintázatának elemzése [balabites terminussal UBA avagy user-behavior analytics], amire természetesen nem csak ők fejlesztettek ki védelmi megoldást, elsősorban kényes adatvagyonnal dolgozó szervezetek számára.

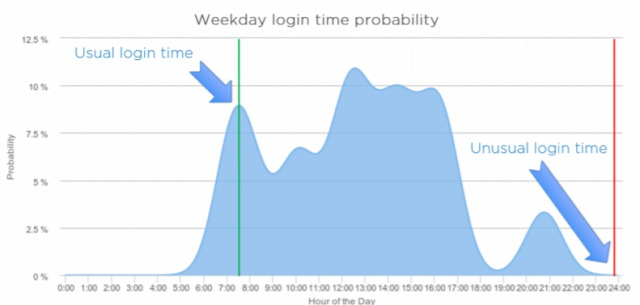

Nézzük legegyszerűbb példaként azt, hogy mi lehet ordítóan feltűnő akkor, ha egy rendszergazda hozzáférését szerzi meg valaki és azzal próbál visszaélni. Ha valaki például adatbázis-adminisztrátorként egy pénzintézeti adatbázisszerverbe hétköznap általában reggel lép be, néha délelőtt vagy délben, a saját ebédidejében nem nagyon, délután ritkábban, éjszaka pedig soha, akkor szinte biztos, hogy ha hajnalban lép be valaki az ő hozzáférését felhasználva, csak támadó lehet.

Intuitív ezt nem olyan nehéz megállapítani. De hogyan lehet felkészíteni a gépet, egy komplex védelmi szoftverrendszert arra az esetre, ha ilyet tapasztal? Ismétcsak a bűvös gépi tanulás úszik be a képbe: valamilyen hatékony gépi tanuló algoritmus bizonyos idő alatt megtanulja, hogy az adott rendszergazda mikor szokott belépni, ezt tárolja, majd valószínűségi alapon riaszt, ha ettől a megszokottól valami merőben eltérőt észlel. Természetesen nem csak időbeli eloszlás tanítható a rendszernek, hanem szinte minden, ami leírja egy felhasználó géphasználati szokásait. Ha valaki szinte mindig a céges hálózatról lép be, kicsit szokatlan, ha otthonról lép be a céges VPN-en keresztül, az pedig már eléggé kritikus, ha képzeletbeli rendszergazdánknál azt tapasztalható, hogy hajnalban próbál belépni olyan IP-címmel, ami mondjuk egy karibi-térségben vagy Kínában jegyzett IP-tartományhoz tartozik.

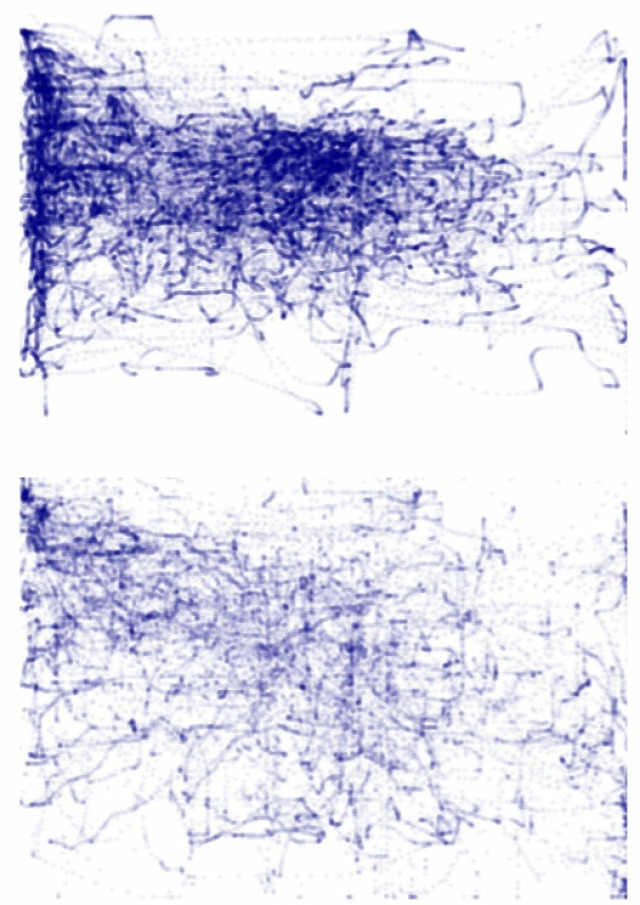

UBA terén ez ráadásul csak a jéghegy csúcsa. Nyilván azzal kapcsolatban is lehet tendenciákat megállapítani adott, magas jogosultságú felhasználóval kapcsolatban, hogy milyen alkalmazásokat használ és mikor vagy milyen parancsokat ad ki egy parancssoros környezetben. Egészen pofás viselkedés alapú ujjlenyomat hozható létre ugyancsak gépi tanuláson keresztül arról, hogy a felhasználónak milyen a billentyűzési dinamikája, azaz a billentyűleütések időbeli eloszlása vagy ami legalább ennyire egyedi, hogyan használja az egeret [itt olyanokra kell gondolni, mint az egérmozgás sebessége, gesztúrái, vagy a kattintásdinamika illetve ezek együttesen és ki tudja még, hogy mi]. Scheidler Balázs egy ilyen, adott felhasználóra jellemző egérhasználati mintázat vizualizált képét is bemutatta.

A teljes védelmi megoldásnak szerves részét képzi, hogy a felhasználókat aszerint, hogy milyen jogosultságaik illetve szerepköreik vannak a cégnél, különböző osztályokba sorolja, azaz a valós-idejű monitorozást az sem zavarja meg, ha több, magas jogosultságú rendszergazdát kell megfigyelni, hiszen köztük is nyilván vannak különbségek többek közt szerepkör szerint, azaz lehet valaki adatbázis adminisztrátor, egy adott virtuális szerver adminisztrátora vagy akár mindenki fölött álló hypervisor admin. Enélkül megoldhatatlan lenne a riasztási szintek skálázhatósága, egyáltalán a riasztási házirend kialakítása.

Az UBA igencsak előremutató, hiszen valakinek a jellemző felhasználói magatartását nem lehet csak úgy meghamisítani, ugyanakkor újabb és újabb kérdéseket vet fel. Tudvalevő, hogy a felhasználói viselkedésből is számos pszichikus nyom nyerhető, konkrétabban olyan jellegzetességek is, amik összefüggésben állnak vagy állhatnak a felhasználó más területen mutatott viselkedésével, ami viszont már nem tartozna másra, ennek megfelelően biztosítani kell, hogy ezek a patternek ne kerülhessenek ki. Hogy világosabb legyen: a Rorschach-tesztnél is a vizsgált személy ábrák láttán adott visszajelzéseiből tudnak pazar leírást adni az illető személyére vonatkozóan, holott a teszt előtt nyilván úgy gondolták volna, hogy a tintapacák értelmezésének első blikkre semmi köze nincs például az illető személyiségvonásaihoz.

Másrészt hosszú út is áll még az UBA előtt, hiszen a gépi tanításon alapuló megoldást fel kell készíteni arra is, hogy egy felhasználó jellegzetes felhasználói viselkedése változhat nyilván akkor, ha más szerepkörbe kerül, ezen kívül ami bennem felmerült, hogy a felhasználói viselkedés finomszerkezetét olyan tényezők is befolyásolhatják, mint különböző gyógyszerek vagy akár élelmiszerek. Ez alatt nem csak arra gondolok, hogy a billentyűzési-egerezési dinamika nyilván más lesz, valamilyen lónyugtató hatása alatt ül a gép elé, esetleg több kávét ivott a kelleténél vagy bepiált, az eltérés elvben akkor is megmutatkozhat, ha valaki alaposan teleeszi magát ebédidőben, majd úgy ül vissza a gép elé. A felhasználói viselkedés mintázata márpedig annál nagyobb „felbontású” lesz, minél több információ gyűlik össze a felhasználóról, az pedig eléggé világos, hogy a fejlesztés iránya az, hogy a felhasználó viselkedésbeli ujjlenyomata legyen minél részletgazdagabb.

Remek kérdés, hogy a felhasználói viselkedés elemzésén alapuló védelem finomhangolásához eléggé gyorsan lehet-e alkalmazni, abba integrálni a magatartástudományi, főként kognitív pszichológiai és neuropszichológiai ismereteket, ahogy történt ez például a nyelvtudomány területén is.

A felhasznált ábrákért köszönet az IDC-nek!

Sophos Naked Security

Sophos Naked Security Securelist

Securelist cyber-secret futurist

cyber-secret futurist I'm, the bookworm

I'm, the bookworm