Amíg rá van pörögve a fél világ a legújabb iPhone-ra, van aki elvből, van, aki nettó gyakorlati megfontolásból addig nem cseréli le a meglévő iPhoneját amíg az nem válik használhatatlanná.

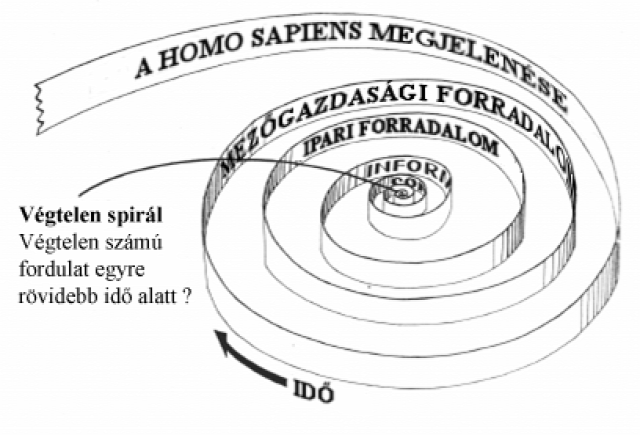

Márpedig az könnyen lehet, hogy soká lesz, oprendszeri frissítést pedig a nagyon súlyos sebezhetőségeket orvosló hotfixeken kívül nem adnak ki hozzá, ugyanakkor mára határozott lassulás tapasztalható a régebbi, frissített iPhone-okon, ellentétben azzal, hogy korábban az Apple foggal-körömmel ragaszkodott hozzá, hogy egy Apple-eszköz nem lehet érezhetően lassabb egy frissítés után akkor sem, ha egyébként régi. A nagyon régieket pedig egyszerűen nincs lehetőség frissíteni.

Mivel attól Apple az Apple, az újabb almás mobilom annak ellenére, hogy öt éves, ugyanúgy működik és alighanem működni is fog egy ideig, ha valaki hasonló cipőben jár, akkor érdemes néhány trükköt alkalmaznia, hogy a vén mobil is elfogadható sebességgel működjön. Azaz hogy kell kikapcsolni azokat a felesleges szarokat, amik csak eszik a rendszererőforrásokat. Kizárólag a hagyományos módon elérhető beállítási lehetőségekre térek ki, azaz olyanra nem, amit az oprendszer BSD-szívcsakrájába való beletúrással lehetne elérni - ha már úgysem jön hozzá frissítés, majdnem mindegy, nem? A leírt tweakek nem jailbreakelt eszközön, iOS 7.x-en biztosan működnek, az Apple-fanatikus cikkek többségében pedig pont ezek nincsenek leírva.

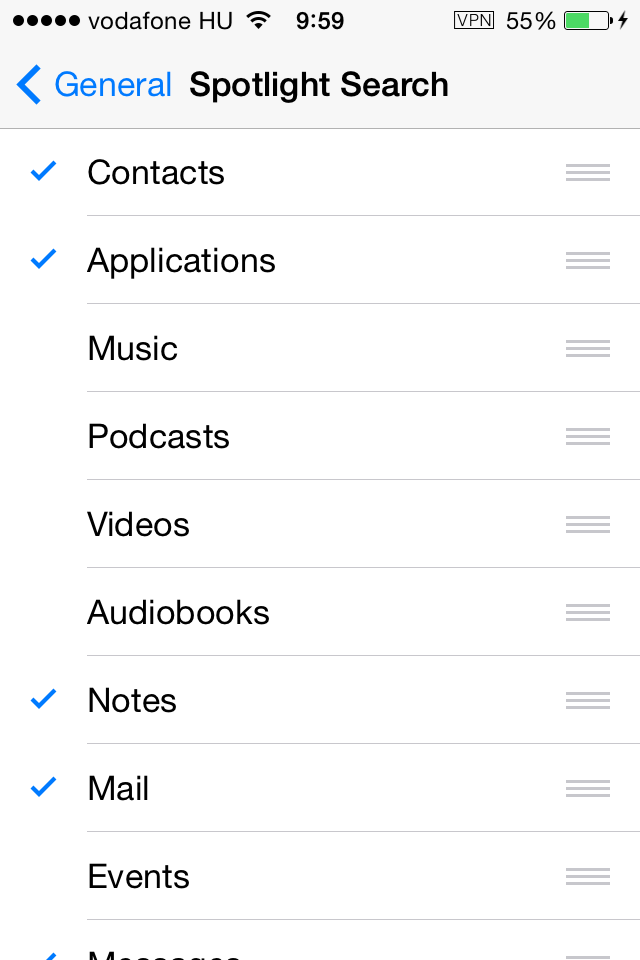

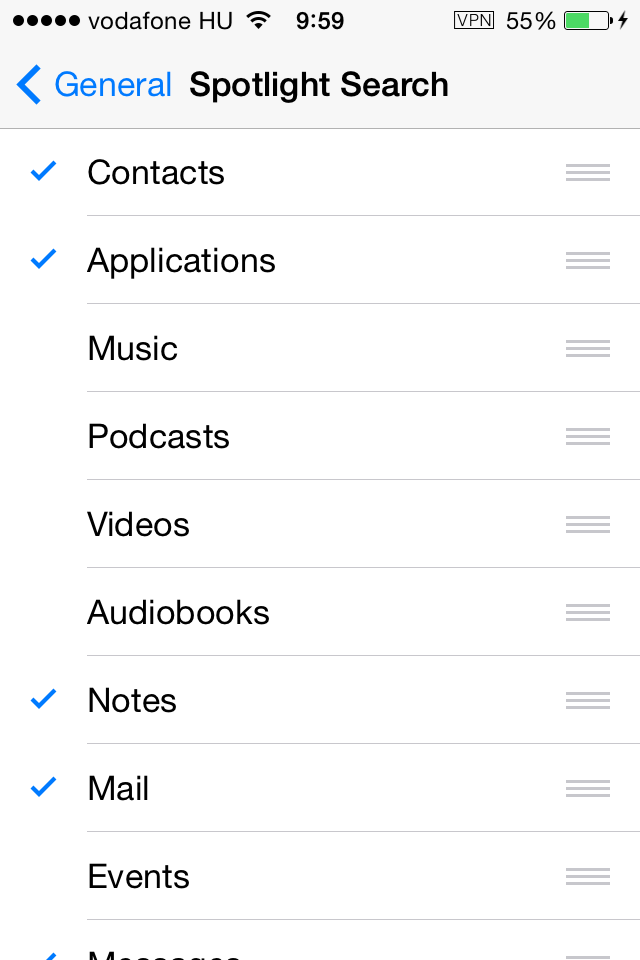

Ó, a Spotlight Search: milyen szép is, ha a megfelelő kulcsszó töredékének a beírásával is megjelenik az az alkalmazás, levél és egyáltalán bármi, amit hirtelen nem találunk, ugye? Amit viszont nem árt figyelembe venni, hogy az eszköznek mindent, aminek azonnal kereshetőnek kell lennie, a maga módján fejben kell tartania, ami folyamatosan igencsak számításigényes bravúrokat igényel, lévén, hogy nincs olyan eszköz, ami mindig mindent a memóriában tárolna, de ahhoz, hogy pl. egy gyors kereséshez a memóriába varázsolja azt, amit kell, igencsak sok követ meg kell mozgatnia a rendszernek, azaz eléggé sok bitet kell talicskáznia össze-vissza a háttérben.

Megoldás: csak azokra a kis memóriaigényű adatforrásokra engedélyezzük a spotlight search-öt, aminél tényleg szükség van rá, ezen kívül tartsuk szem előtt az ésszerűséget. Ha például a Mail alkalmazásban úgyis van saját kereső, értelmetlen itt is indexeltetni.

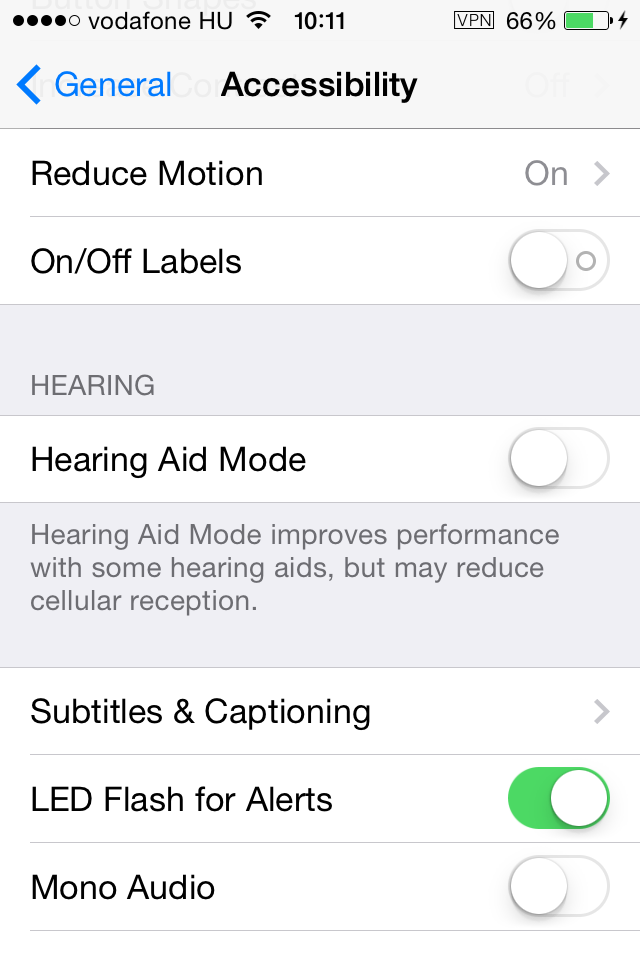

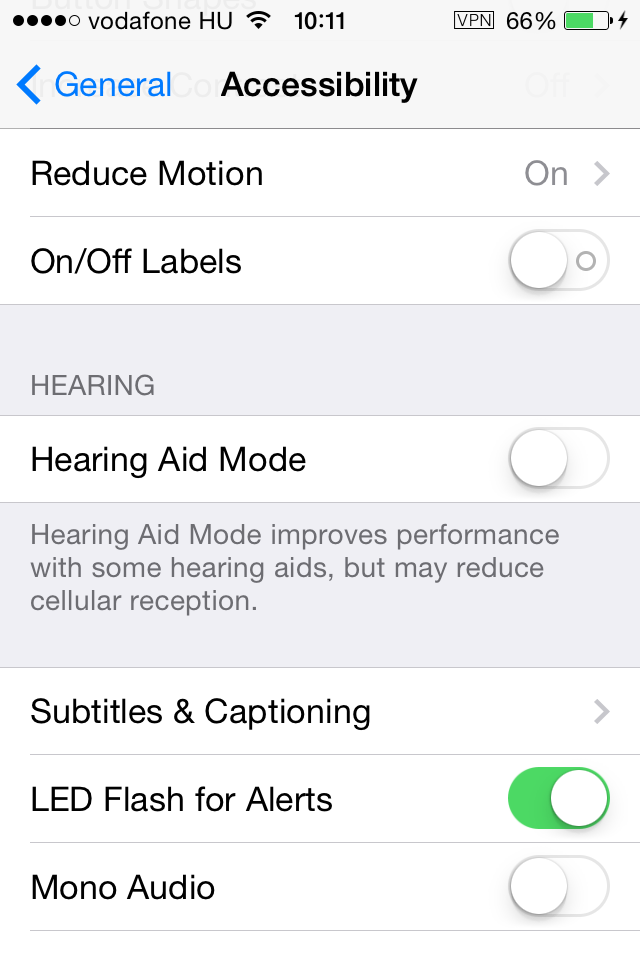

Az iOS 7 megjelenésével még több, felhasználói élményt fokozó effekt került a rendszerbe, ami valóban fokozta a felhasználói élményt olyan iPhoneok esetében, amik rogyásig voltak memóriával és erős GPU-val szerelték őket, akik régebbit használnak, azoknak aligha volt élmény az, hogy minden lassabban érhető el, csak azért, mert a képernyőn az effektek kifinomultabbak. Ami kétségkívül jó tulajdonsága, hogy szépen le lehet kapcsolni és az életbe nem kell vele foglalkozni, persze a korábbi verziókból megszokott effektek ettől még maradnak.

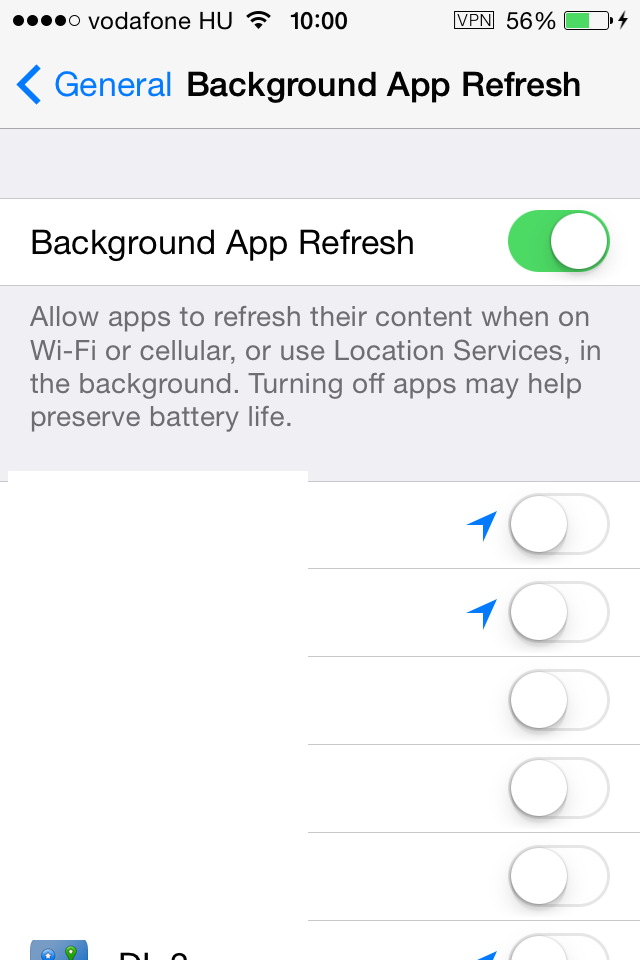

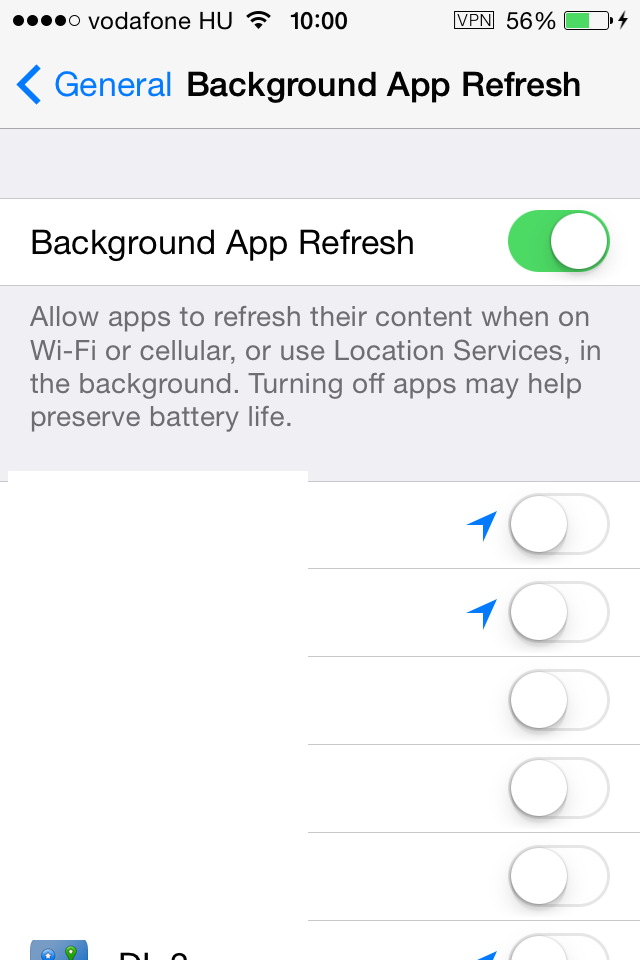

Jó ötletnek tűnik ugyan, hogy egy alkalmazás a saját adatait akkor is frissíthesse, amikor egyébként a háttérben fut, mi pedig esetleg közben használunk teljesen más alkalmazást, az egész tipikusan fölöslegesen zabálja az erőforrásokat, ami az újabb iPhone-oknál nem érződik, viszont mindez használja a hálózatot és túráztatja az akkumlátort is.

Az Apple a végfelhasználók számára a mobileszközei esetén végképp nem tette egyértelművé és egyszerűen ellenőrizhetővé, hogy mit jelent pontosan, ha egy alkalmazás a háttérben fut, tétlen, folyamatosan fut valamilyen módon a háttérben vagy egyáltalán nem fut. Az világos, hogy a rendszer igen kifinomultan figyeli, hogy melyik alkalmazást milyen gyakorisággal használjuk, ennek megfelelően a gyakran használt appok fürgébben is ugranak elő. Ezért van, hogy elképzelhetetlen az az Android-környezetből ismert jelenség, hogy kevés memória esetén lelassul az egész és alkalmazásokat kézileg kell bezárni. Iphone esetén míg például a Hangouts akkor is figyel és fogad hívásokat, ha épp bekapcsoltuk a telefont és el sem indítottuk az alkalmazást, ezzel szemben mondjuk a Skypeon csak akkor vagyunk hívhatók, ha az utolsó megnyitás után nem volt konkrétan tétlen, hiába van ott a futó alkalmazások közt. Hasonlóan zavaros, hogy mit jelent az, hogy egy alkalmazás a háttérben ügyködhet-e. Nos, mivel a jólnevelt alkalmazás egyébként is úgy van megírva, hogy amit a felhasználó nem mentett el, amikor érzékeli, hogy épp a felhasználó bezárja, elmenti az adatot, így például az Evernote vagy a Notes egy feljegyzést ment akkor is, ha csak bezárjuk, ehhez nem kell a háttérben futnia. A példánál maradva, ha azt szeretnénk, hogy a következő indításkor már a máshonnan megejtett szerkesztések is azonnal láthatók legyenek, akkor ezt ez a megoldás biztosítja, az esetek többségében viszont semmi szükség rá, így kikapcsolható. Ha a háttérben nincs frissítve, csak akkor frissíti pl. az Evernote a jegyzeteket, amikor legközelebb indítjuk, ennek megfelelően lassabban indul, de közben a rendszer annyival lesz gyorsabb, amikor a konkrét alkalmazás nem fut, de másvalamit használunk. Azaz igaz, egy-egy indítás több időt fog igénybe venni, például a Facebook vagy a LinkedIN nem azonnal mutatja a fal legfrissebb állapotát, hanem az indításnál frissíti azt, erre egyébként is csak akkor van szükség, ha az appot használjuk.

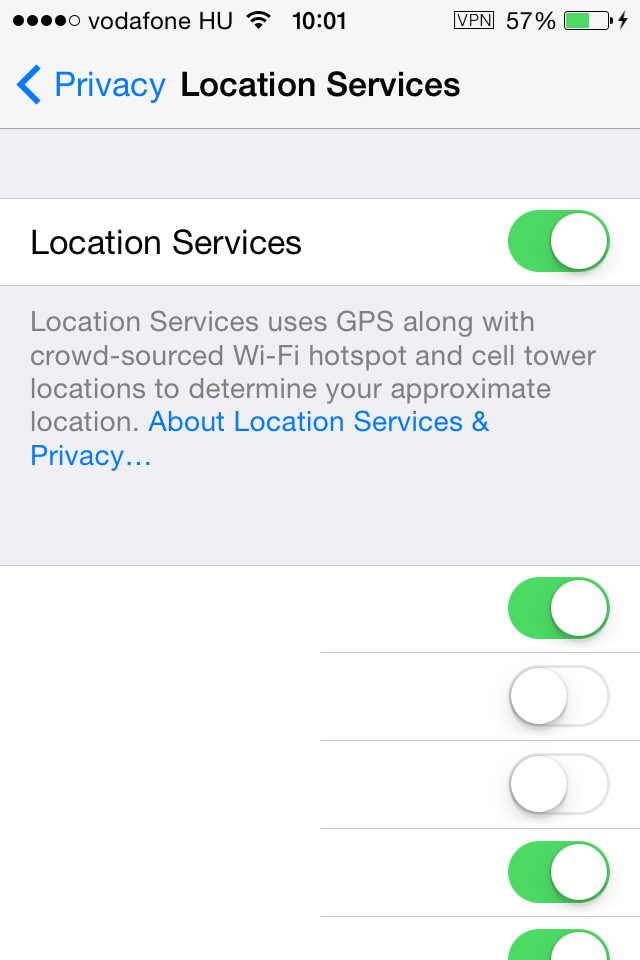

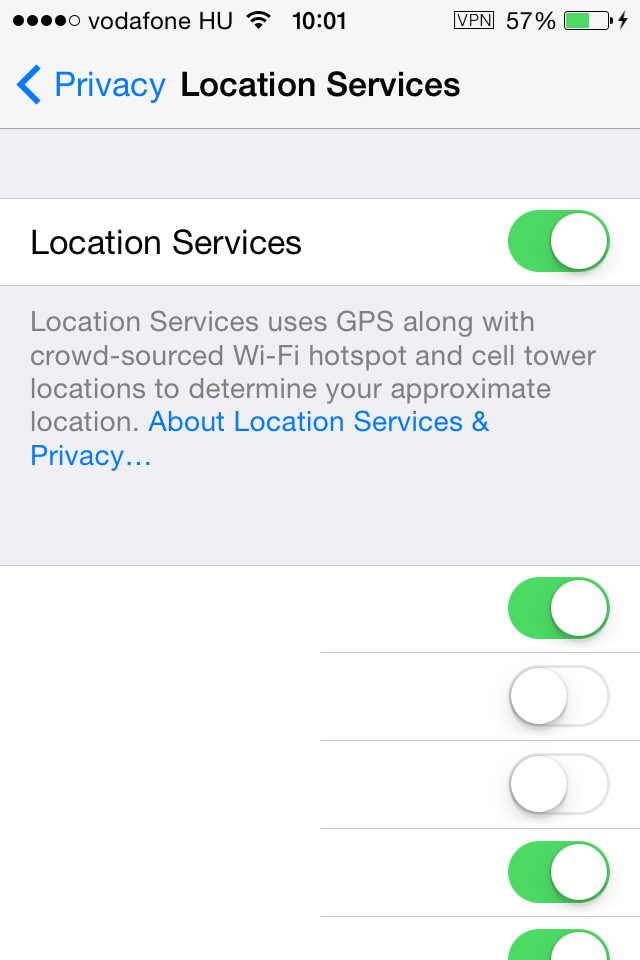

Vegyük észre, hogy az előző a helymeghatározási funkcióval is összefügg. Azaz egy háttérben futó alkalmazás rendszeresen lekérheti a geoinfókat, sokszor fölöslegesen, ami tovább zabálja az erőforrásokat. Több szállodafoglaló app van, ami még abban az esetben is, ha meg se nyitottuk és otthon ülünk, a háttérben rendszeresen megnézi, hogy hol vagyunk, hogy annak megfelelően, közelben lévő szállodát tudjon ajánlani, a leggyorsabban, ha megnyitnánk. Nos, ha mondjuk valami elborult vidékre utazunk, hasznos lehet, hogy helyi információkat figyelembe véve és a leggyorsabban jelenjen meg a kínálat, nyilván ez a ritkább eset.

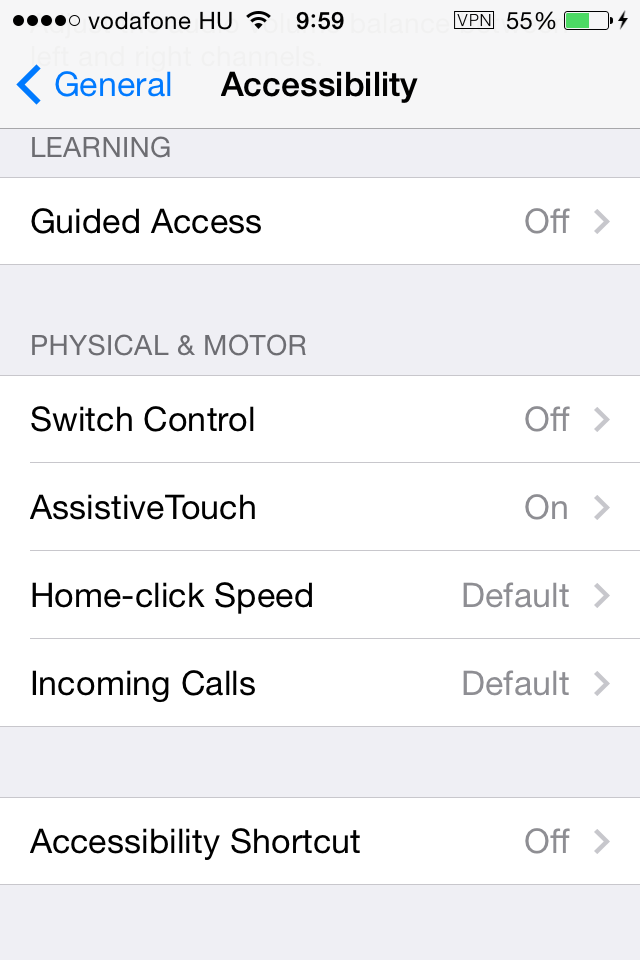

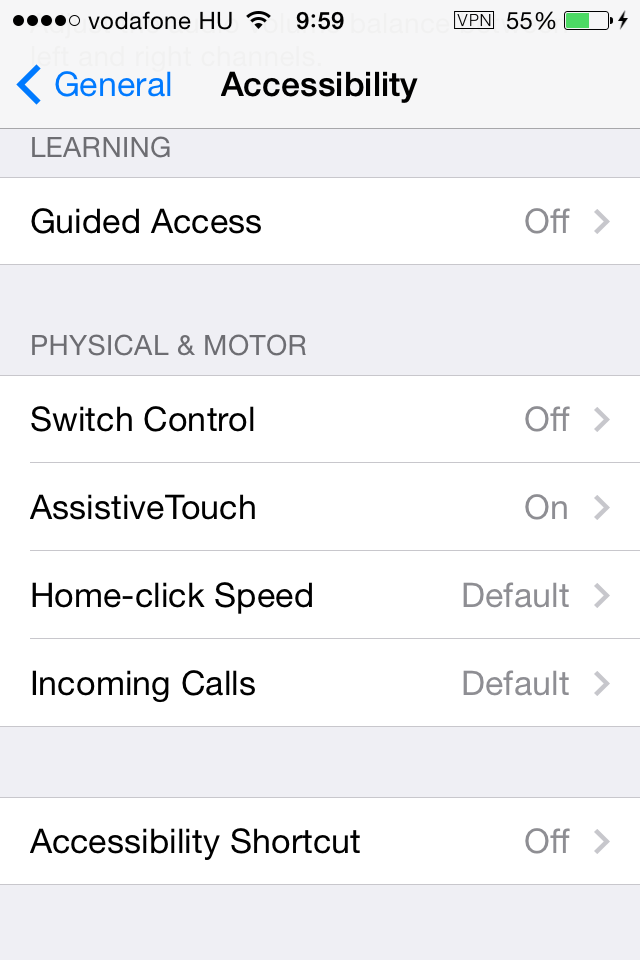

Az Assistive Touch bekapcsolásával viszont kapunk plusz egy Home gombot, ami amellett, hogy a valódi Home gombot kíméli azon keresztül, hogy azt ritkábban kell nyomkodni, mivel amellett vagy helyett is használható, gyorsan előcibálhatóvá tesz olyan lehetőségeket, amik gyors telefon esetén egyébként is gyorsak, lassúnál viszont határozottan lassabbak, ilyen például a multitasking, ráadásul egyéni gyorsindítók is beállíthatók ún. gesztúrák rögzítésével.

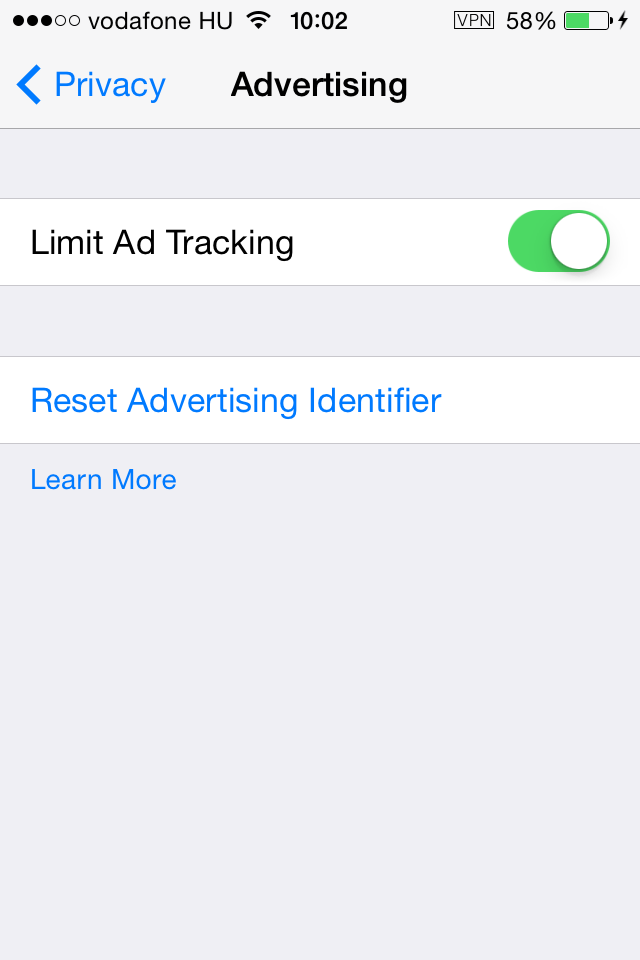

Az, hogy különböző alkalmazásokban személyre szabott reklámokat jelenít meg, inkább privacy szempontból érdekes, viszont annak is megvan a maga számításigénye, hogy gyűjtse a felhasználói szokásainkat és ennek megfelelően jelenítse meg a testre szabott reklámokat, amikor kell. A dolog kísértetiesen hasonlít a Google hirdetés-perszonalizációjához: egy totálisan eldugott helyen, de kikapcsolható.

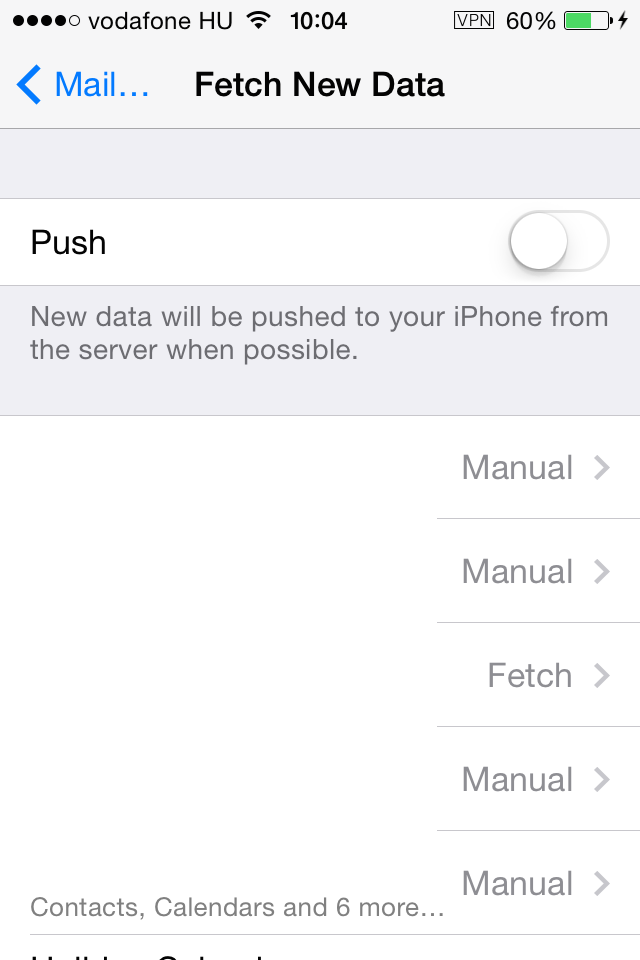

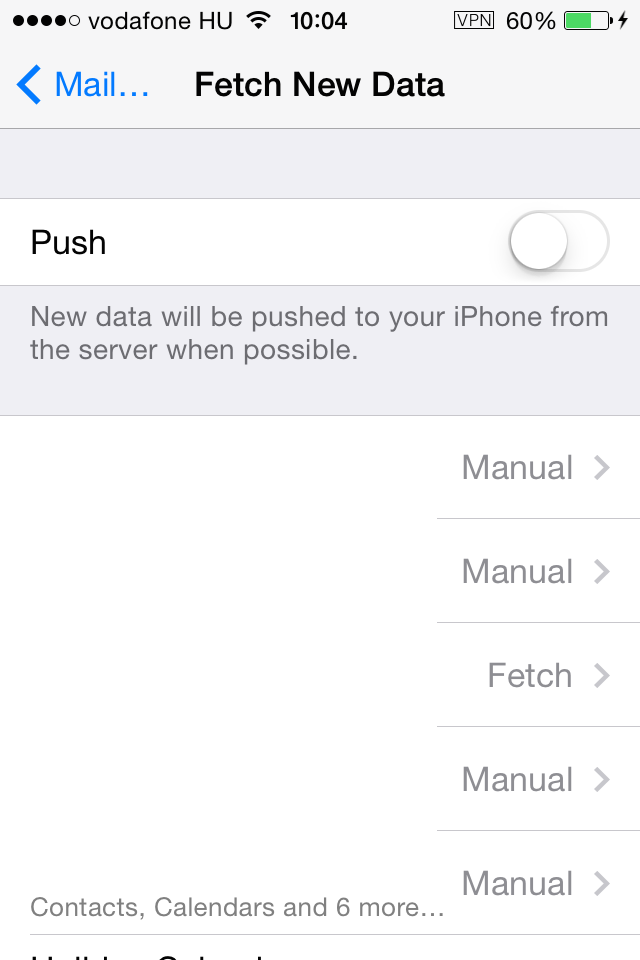

Ha van valami, ami nem változott az iPhone-ok evolúciójában, az az, hogy az egyik legnagyobb akkumlátorgyilkos a levelezőalkalmazás. Ahogy több helyen is olvasható, ha több olyan postafiók is be van állítva, aminek a tartalmát rendszeresen nézegetnie kell a rendszernek és jeleznie, ha levelet hozott a posta, drámaian gyorsabban merül az akku. Ami viszont fontos, hogy fiókonként külön-külön állítható be, hogy a tartalmukat a rendszer milyen időközönként ellenőrizze, esetleg soha, csak amikor kézileg nyitjuk meg vagy éppenséggel a funkciót támogató szolgáltató push-üzenetként értesítsen-e egy-egy új emailről. Gondolkozzunk kicsit gyakorlatiasan: ha valakinek überelhetetlenül sürgős valami, az úgyis fel fog hívni, nem pedig emailt ír vagy SMS-t. Ha nem olyan témáról van szó, ami eszelősen sürgős lenne, akkor úgyis ráér addig, amíg legközelebb kézbe veszem a mobilom, amelyiken látom, hogy olvasatlan email van a postafiókban, a boríték ikonja melletti számból, aztán elolvasom a levelet. Ez esetben viszont teljesen mindegy, hogy a levelek rendszeresen negyedóránként, félóránként, óránként töltődnek le vagy gyakorlatilag azonnal, mert IMHO normális ember úgysem fog gyorsabban válaszolni, mert gyorsabban értesült egy új emailről. Ha belegondolok, hogy mennyi levél érkezik hozzám naponta, egy fél fejezetet nem tudnék elolvasni egy könyvből vagy éppen teljesen esélytelen lenne koncentrálni normálisan bármire is, ha azonnal megnézném az emailjeimet, amikor azok érkeznek. Nem csak akkugyilkos, de értelmes tevékenységet végző ember számra értelmetlen is a levelek túl gyakori auto-fetchelése, óránkénti beállítás bőven elég. Hasonlóan vagyok a Facebook-üzenetekkel, a Messengert elvből nem telepítettem, aki írt, attól kéretik szépen megvárni, amíg gép előtt leszek vagy felhív. Az alapértelmezett push-t mindenhol érdemes kikapcsolni a levelezőalkalmazás beállításainál.

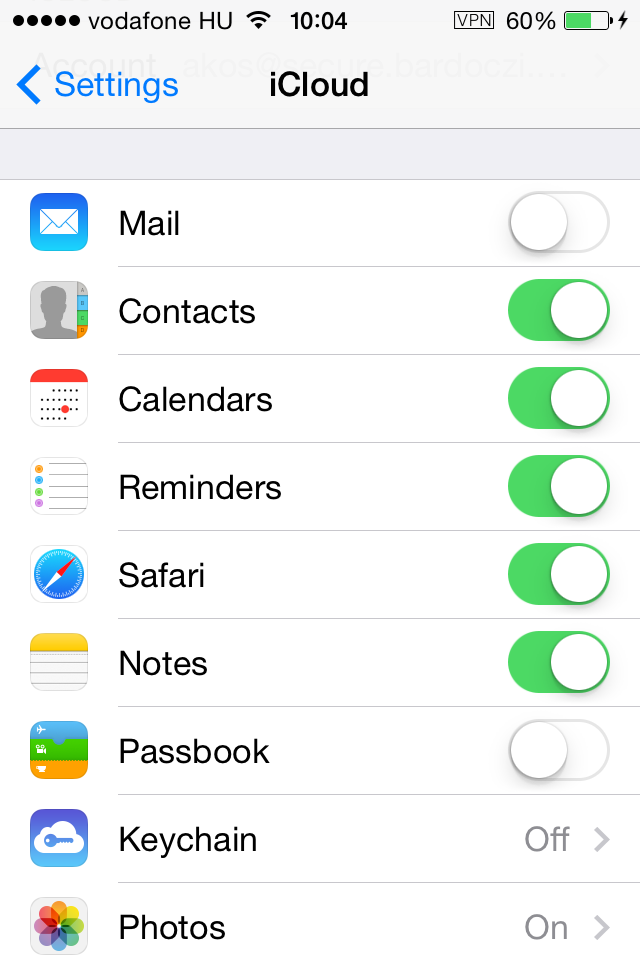

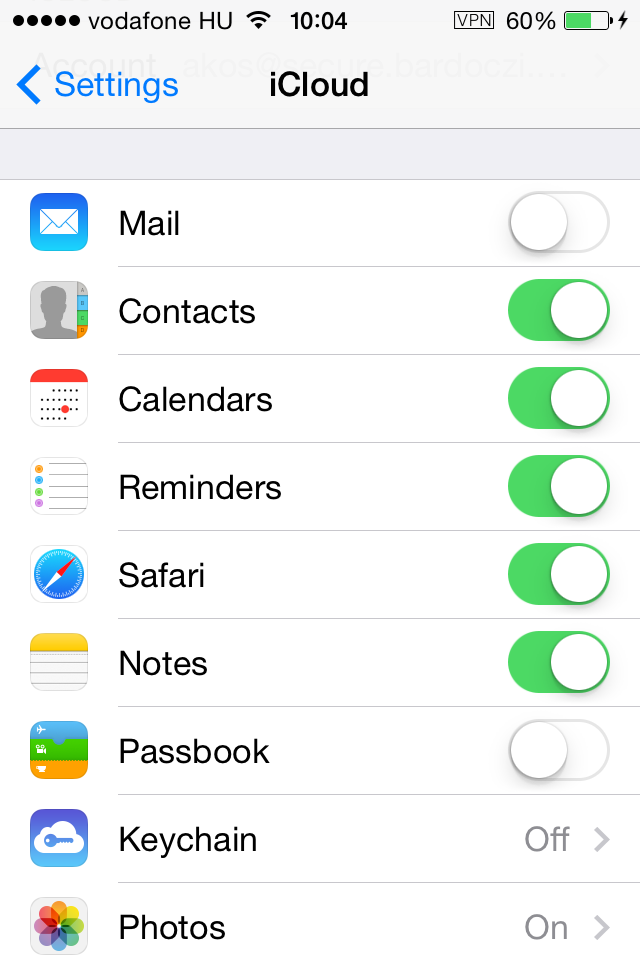

Apple-eszközt használni iCloud nélkül elvben lehet, gyakorlatilag nagyon nem érdemes. Ehhez viszont kapcsolódik egy rakás értelmetlen trágya is, amit vagy használunk vagy nem, esetleg használat közben megszokunk. Nincs általános recept, nekem jó, ha a képek azonnal megnézhetők a gépen is, mivel azok ugye automatikusan töltődnek a felhőbe, ha használjuk [ezért halálosan ostoba a nagyokos Apple-fanoknak az az érvelése, hogy miért nem nagyobb az újabb iPhone háttértára - mert arra ott az iCloud, csókolom! Ha ott fenn van akár a fotó, akár a videó, már törölhető a mobilról.]. Ugyanakkor most komolyan, nevezze már meg valaki 5 ismerősét, amelyik az Apple levelezőszolgáltatását használja! Na ugye, alighanem mi sem használjuk, valószínűleg fölösleges is, kilőhető, az meg most nem ide tartozik, hogy egyébként sem túl bölcs rajta levelezni, mert amiről az Apple úgy gondolja, hogy spam, az a levél az életbe nem lesz meg.

A billentyűzárnak látszólag nincs sok köze a teljesítményhez, figyelembe kell venni, hogy nem azonos a képernyőzárral, - azaz amikor a mobil egyszerűen lekapcsolja a képernyőt - és a passcode által védett billentyűzár, ami csak megadott jelszó vagy számkód helyes megadása esetén engedi a mobilt használni. A kettő nem feltétlenül azonos, az előbbi lehet rövid idő, az utóbbi pedig értelemszerűen több perc, azaz például csak akkor kérjen billentyűzárat, ha a tétlenség elérte az 5 percet, addig viszont a mobil szabadon feloldható, nem is eszi az akkut a kijelző, ugyanakkor a szükségesnél gyakrabban sem kell bekalapálni a billentyűzárat.

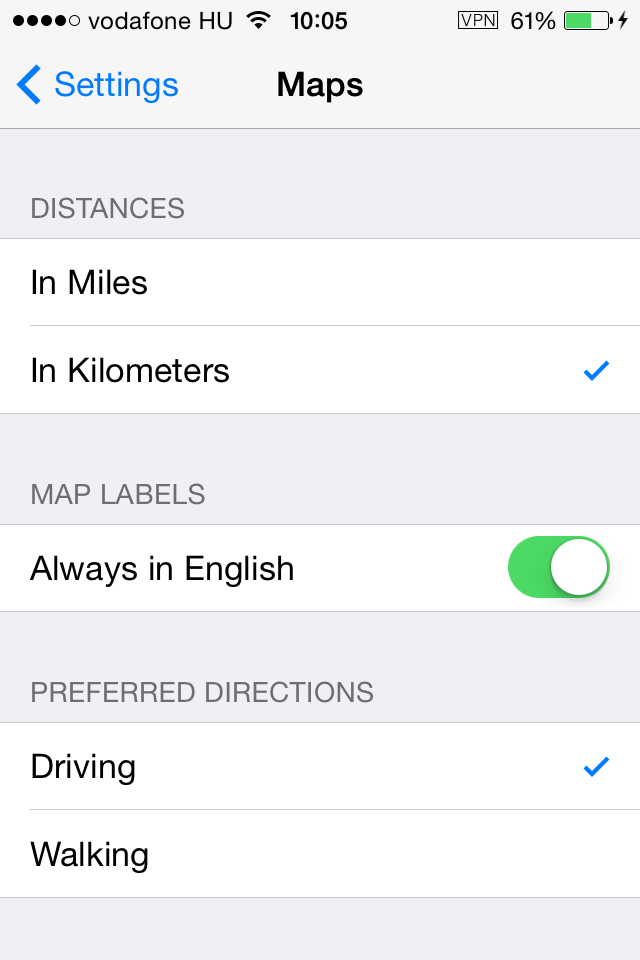

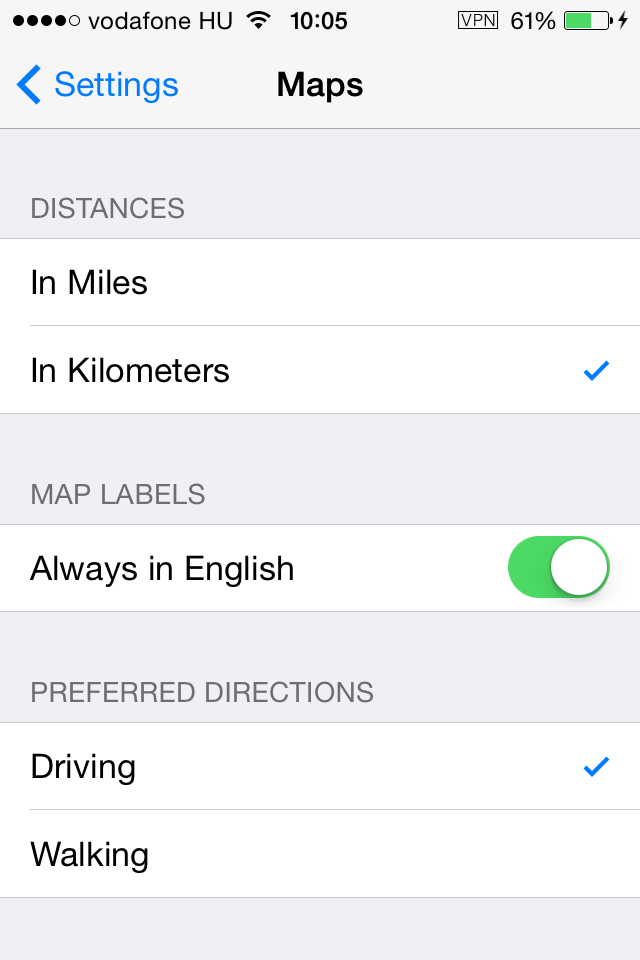

Nem a teljesítményhez, hanem kőkeményen a usabilityhez tartozó kérdés a térkép angol feliratozása, ami addig nem feltűnő, amíg nem utazunk nagyon messzire. Nos, tételezzük fel, hogy valaki meg elutazik, de nemhogy az ottani nyelvet nem beszéli, hanem még a helyi ábécét sem ismeri. Még én sem merném bevállalni azt, hogy az alkalmazás Moszkvába utazva a térképet kizárólag cirill betűkkel feiratozza, ahogy arab országba utazva sem azt, hogy kizárólag arabul, még akkor sem, ha már bőven a 20. században egyszerűsített arabot használják, amit ismerek valamennyire. Például egy háromszáz évvel ezelőtt élt író, akiről elneveztek valamilyen közterületet, nem fogják a nevét csak azért az új, a 20. századi, egyszerűsített arab nyelven kiírni, hogy a térképalkalmazások használhatóbbak legyenek. Az más kérdés, hogy aki távoli országba utazik, egy ottani térképalkalmazással szinte biztos, hogy jobban jár, Oroszország esetén mondjuk ilyen a Yandex Maps. Az alapértelmezett beállítás viszont az, hogy az iOS beépített térképe a helyi nyelven feliratozza a térképet, angolul ne. Akárhogy is, erősen érdemes bekapcsolni az angol feliratozást. Ha kénytelen lennél tárgyalni mondjuk egy reptéri urándetektor vezérlőszoftverének frissítéséről Dubaiban vagy Moszkvában, alighanem a helyi illetékesekkel szivesebben beszélnél angol nyelven, hiába gagyogsz oroszul vagy arabul.

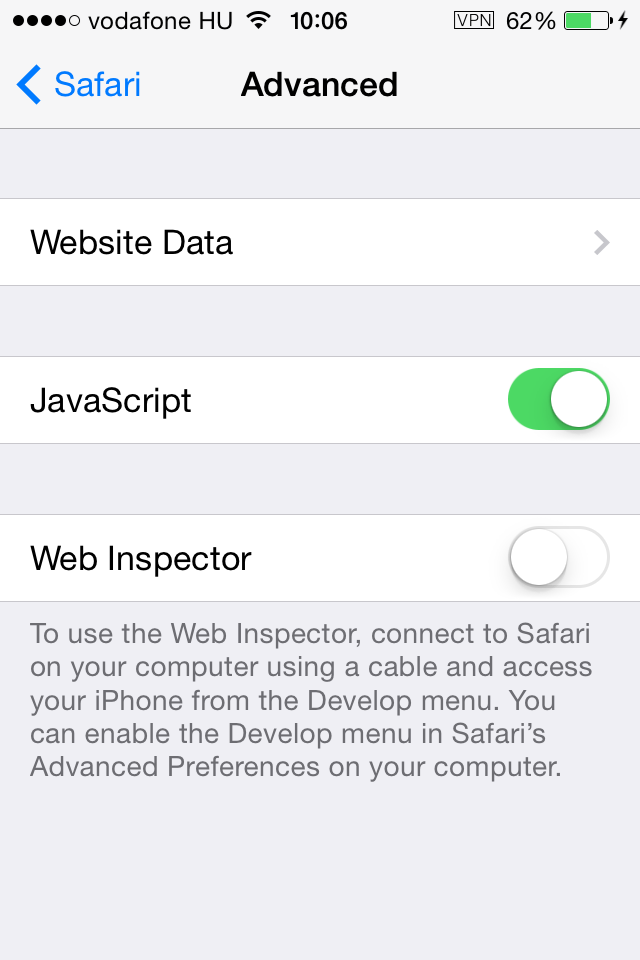

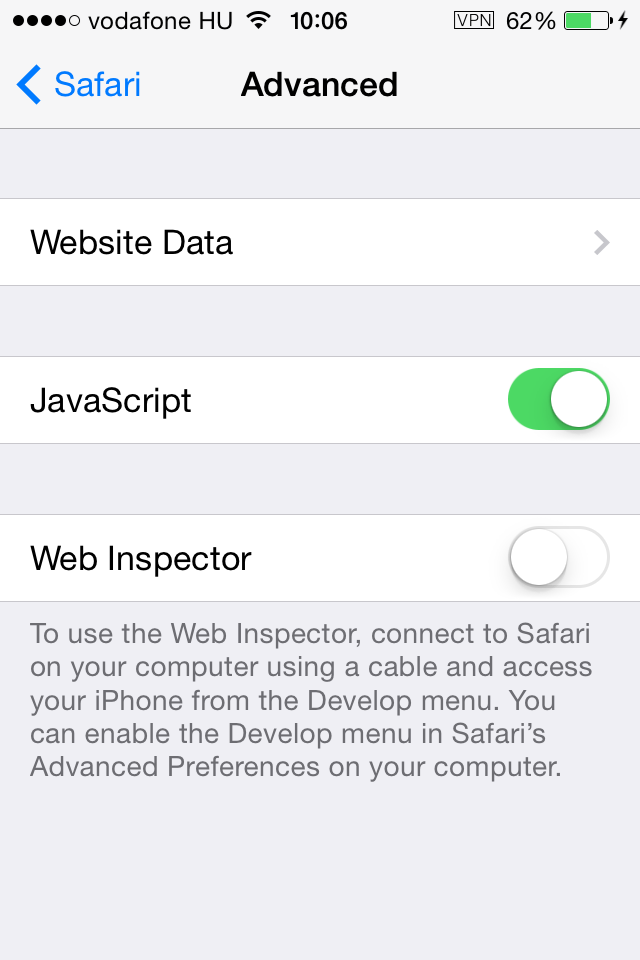

Külön posztsorozatot érne meg, hogy miért érdemes a DNT-t lekapcsolni és a böngésző helyben tárolt adatait néha törölni. Akármilyen környezetről is legyen szó, ha az adattárolást kell megoldani, nem csak a nagy mennyiségű adat, hanem a sok, elaprózott adat kezelése is számításigényes, márpedig a böngészők gyorsítótára tipikusan ilyen.

Hosszú lenne fejtegetni, másrészt messze nem a területem, de éppen az előző indoklás miatt azt a gyorsítótárat is érdemes üríteni néha, ami ugyanitt "Website Data" néven jelenik meg.

Egyébként az a kérdésfeltevés, hogy "Milyen telefont érdemes venni?" vagy épp "Melyik a legjobb?" a többség tudatában hitkérdés és nem, attól, mert valaki ki tud rootolni egy androidos mobilt vagy jailbreakelni egy iPhone-t, attól még nem ért hozzá. De tényleg, mennyi olyan ember van, akivel érdemben lehet vitázni arról, hogy mindennapos használathoz, üzleti környezetben való használathoz vagy melyik a legalkalmasabb és miért?

Az ön- és közveszélyes Android ugyan tipikusan sokak tudatlanságára játszva éppen fordítva szokta mondani, de nem 2-3, hanem 5-7 éves lemaradásban van az iOS-hez képest, nincs általános recept arra, hogy milyen mobilt érdemes választani, ezért példaként írok néhány forgatókönyvet.

Ha megkérdezik tőlem, hogy egy céges flottához milyen céges mobilt ajánlanék, ahol számításba kell venni, hogy az alkalmazott esetleg elhagyja vagy célzottan ellopják tőle az eszközt azért, hogy arról adatokat nyerjenek ki, ugyanakkor a mobil mégsem lehet veszett drága, mert kapásból vennének belőle 300 darabot, mégis az Androidot ajánlanám. Igaz, hogy normálisan megvalósítva az operációs rendszer beépített funkciójaként a háttértár titkosítása csak a 4.3-4.4-től* létezik, ami laza 4 év lemaradás az Applehöz képest, ahol az iPhone 3GS-től kezdődően mindben alapértelmezés szerint titkosított** a teljes adattartalom, ráadásul nem opcionálisan, hanem kapcsolhatatlanul. A választás azért esne mégis az Androidra, mert relatív olcsó és számtalan olcsó távmenedzsment szoftver vásárolható hozzá, amit a saját megoldásaival kombinálva egy cég még jobban testre szabhatna később.

Ha megkérdezne egy rokonom, hogy milyen mobilt vegyen, azt mondanám, hogy iPhone-t, mivel stabil, gyors, sosem hal le, para pedig akkor sincs, ha ellopják tőle, mivel a rajta lévő adattartalomhoz hozzáférni szinte lehetetlen a billentyűzár ismerete nélkül.

Ha olyan cég kérdezne, amelyiknél a céges csapatmunka minden részét valamilyen Microsoftos megoldással végzik jóideje és azzal is folytatnák, akkor nem túl drága Windows Phone-os mobilokat javasolnék. Igaz ugyan, hogy idővel elérhetőek lettek vagy lesznek más platformokon is azok az eszközök, amik tipikusan a MS üzleti megoldásai, mint mondjuk a céges chatnek nevezhető Lync, a csapatmunka svájcibicskájaként működő SharePoint vagy a levelezőrendszerek luxusverdája, az Exchange, ezek nem meglepő módon Microsoft-termékként Windows Phone-on működnek a legjobban. Hasonlóan ahhoz, hogy iPhone-on is lehet a Safarin kívül más böngészőt használni, csak éppen lassabb lesz. így például a MS Exchange postafiók beállítható Androidon is, lassú lesz, mint a vesztés.

Azaz elvben minden komoly szolgáltatás vagy alkalmazás létezik általában több platformra is, csak a teljesítményben vannak elképesztő eltérések, ezen kívül hosszú távon gondolkozva a költséghatékonyság és időtállóság eléggé erős szempont.

Ha már mobilok adatitkosítása, két lábjegyzettel zárnék.

*az Android esetén az első, de nem túl komolyan vehető titkosítás, mint natív operációs rendszeri funkció, a 3.0-tól létezik, ami pedig a komolyabb kriptomegoldást jelenti, a 4.3-ban jelent meg, de anno nem tartott sokáig az öröm, mert a legújabb verzión is lazán fel lehetett pattintani a titkosítást, a módszert amúgy elsőként magyar kutatók hozták nyilvánosságra

**az iOS rendszerek esetén a ma elterjedten használt verziók terén nem tudok róla, hogy találtak volna kihasználható hibát a titkosított adatok kinyerésére. Ez a gyakorlatban nem jelenti azt, hogy hozzáférhetetlenebb: idevágó kérdés, hogy minden főverziónál találnak valami arcpirító baromságot, amin keresztül a billentyűzár ismerete nélkül, valamelyik kényelmi funkción át is feloldható a mobil, ezeket a hibákat rendszerint azonnal javította az Apple.

Egy idén nyáron megjelent sokkoló kutatás ugyan az andoridos mobilok esetén igazolta, gyakorlatilag belátható, hogy platformfüggetlen tulajdonság, hogy ha a felhasználók számsorként túl egyszerű billentyűzárat vagy feloldási mintát állítanak be, mindegy, hogy a mobil oprendszerének gyártója milyen módon valósította meg az adatok titkosítását, pusztán számokból álló billentyűzár esetén 8 számjegyűnél rövidebb kód egyszerűen nem biztonságos, Androidban minta alapján történő feloldásnál csak ésszerűtlenül hosszú lenne az. Az ujjlenyomatolvasós megoldások biztos nagyon fancy-k a felhasználóknak, nekem pedig megmosolyogtatóak, hiszen alapvetően eléggé baromság olyan azonosítót használni bármiféle autentikációhoz, amit az ember ezer helyen otthagy, lenyúlni viszonylag egyszerű, a 3D nyomtatás korában pedig bárki varázsolhat lopott minta alapján ujjlenyomat-másolatot. Arról nem is beszélve, hogy több olyan módszer található a neten, ami azt írja le, hogy tényleg barkács módszerrel téveszthető meg egyik-másik ujjlenyomatolvasó. Hogy az ésszerű áron beszerezhető biometrikus azonosításon alapuló módszerek használata miért hülyeség, hosszú mese lenne, de elég csak belegondolni, hogy retinán alapuló azonosításnál, a retina ugyan eléggé lekoppinthatatlan ugyan, de az olyan retinaszkenner, amit nem lehet megtéveszteni, már eszelősen drága, márpedig a közelgő legnagyobb őrület, ha igaz, a mobilokba épített retinaszkenner/írisz-szkenner. Ezekkel nem csak az a baj, hogy szimplán jópofa ostobaságok, mondjuk az adatokat a zsebtolvajtól megvédi, de célzott adatlopástól annyira védenek, mint Árpi bácsi bunkere az atomtámadás ellen. A nagy probléma az, hogy hamis biztonságérzetet keltenek a felhasználóban. Ugyanis a felhasználók annyira nem vágják, hogy valami hogyan működik, hogy nagyon sokaknak egy elfogadható, szemléletes képe sincs olyanról, amit jó tudni a mobil kapcsán. Blackberry felhasználóként beszéltem olyan Blackberry-tulajjal, aki meg volt róla győződve, hogy ha mi telefonálunk egymással, akkor az titkosított, de inkább nem futottam neki magyarázni, hogy ha a hívást nem a Blackberry Messengerében indítjuk, ami áttolja a hívást egy BIS/BES szerveren, ugyanolyan mezei telefonhívás, mint bármely másik.

Sophos Naked Security

Sophos Naked Security Securelist

Securelist cyber-secret futurist

cyber-secret futurist I'm, the bookworm

I'm, the bookworm